Neurologie

ChatGPT et cas cliniques de neurologie : cet IA a-t-elle la neurophobie ?

ChatGPT a marqué l’année 2023 en disséminant au grand public la technologie des grands modèles de langage. La versatilité de cette technologie d’intelligence artificielle (IA) l’a amenée à être évaluée pour divers usages consistant en des tâches cognitives de plus ou moins haut niveau. En médecine, le raisonnement clinique fait partie des tâches cognitives de plus haut niveau. En neurologie, celui-ci s’appuie particulièrement sur la richesse de l’anamnèse et de l’examen clinique, ainsi que sur la recherche d’une systématisation du tableau clinique. Deux neurologues de Stanford et Austin ont évalué la performance diagnostique de la dernière génération de grand modèle de langage « Generative Pre-trained Transformer 4 » (GPT-4) sur des cas cliniques de neurologie (Galetta and Meltzer, 2023).

- Robert Way/istock

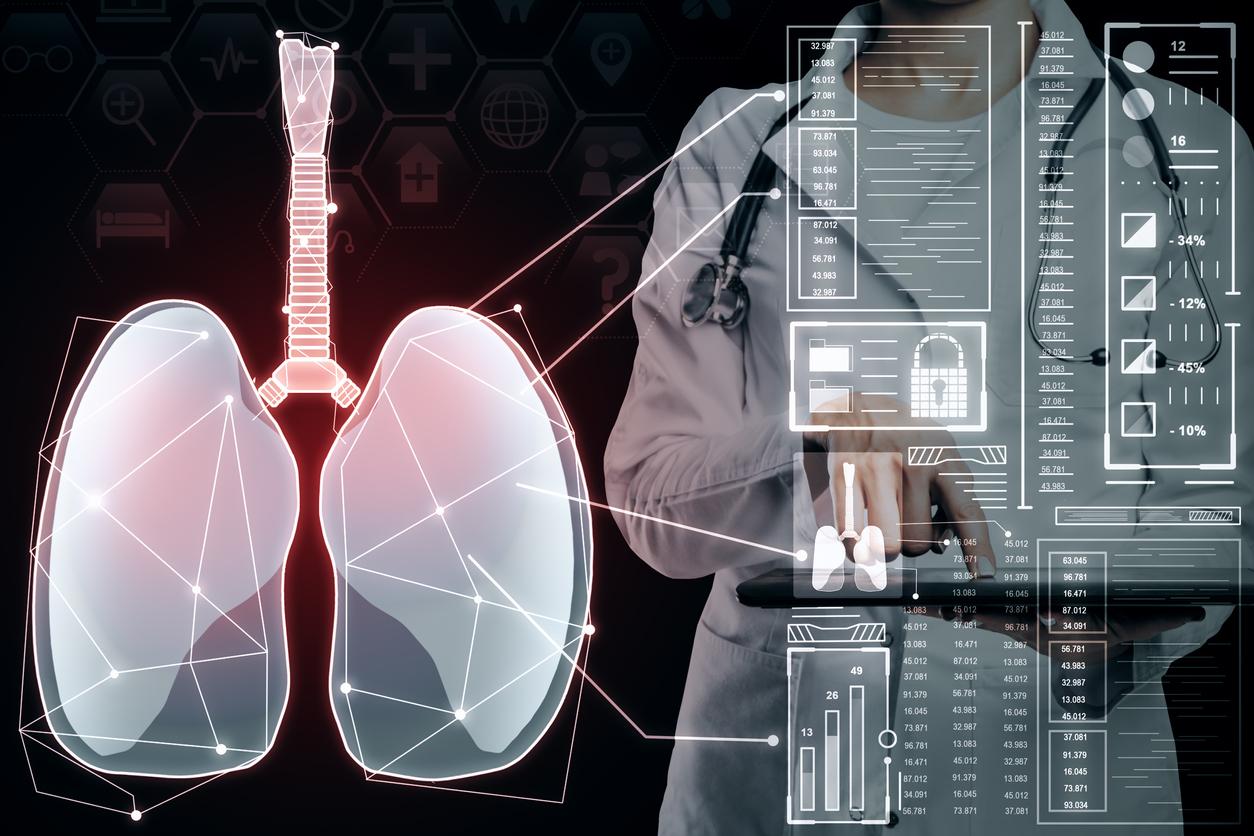

À ce jour, l’implémentation de l’IA en médecine s’est limitée à des cas d’usage bien précis, notamment le post-traitement de données comme l’imagerie. ChatGPT est un chatbot mis à disposition du grand public et permettant d’interagir avec un grand modèle de langage « generative pre-trained transformer 3.5 » (GPT-3.5), qui est une technologie d’IA bien plus versatile que des modèles de classification ou de régression courants. ChatGPT apparaît donc comme une IA générale (en anglais : general-purpose), ce d’autant que GPT-4, le modèle de nouvelle génération, a été entrainé sur une base de données plus grande, a été plus raffiné et est capable de prendre du texte et/ou des images en entrée (on parle d’IA multimodale). De nombreux usages médicaux ont immédiatement été imaginés pour le soin, les tâches administratives, la recherche et l’enseignement (Lee et al., 2023).

Résoudre des cas cliniques de neurologie pose des défis propres comparé à d’autres disciplines médicales. Beaucoup de pathologies sont diagnostiquées sur la base de l’anamnèse et de l’examen clinique. Le neurologue est un expert pour prioriser les informations a recueillir pour générer des hypothèses sur la localisation d’une lésion et hiérarchiser les diagnostics différentiels possibles. L’étape de systématisation du tableau clinique se base sur une connaissance neuroanatomique pour interpréter l’examen du système nerveux qui n’est qu’indirect. Ce besoin d’abstraction accru suscite de la neurophobie auprès des étudiants (Jozefowicz, 1994) ou des séniors d’autres spécialités. En revanche, une IA n’est ni limitée en charge mentale ni en mémoire de travail et la complexité de son algorithme peut lui permettre d’apprendre des représentations d’immenses corpus de connaissances fondamentales. Les auteurs ont donc fait l’hypothèse que GPT-4 serait hautement performant pour systématiser des tableaux cliniques et lister les diagnostiques différentiels pertinents.

Une évaluation sur des cas cliniques de neurologie

Vingt-neuf cas cliniques publiés par le second auteur dans un manuel de neurologie clinique furent utilisés (Meltzer, 2022). Chacun des cas était conçus pour être soluble cliniquement sans examen complémentaire. Les cas furent classés comme « simples » ou « difficiles » sur la base des retours de 7 internes dans les hôpitaux de chaque auteur.

La saisie de l’instruction pour le chatbot (en anglais : prompt) fut standardisée. Une nouvelle conversation fut démarrée pour chaque cas. La saisie annonçait clairement qu’elle décrivait un cas clinique, dont le diagnostic neurologique était inconnu. Elle demandait de lister les 3 localisations lésionnelles et les 3 diagnostics de maladie les plus probables et de proposer les 2 examens complémentaires les plus à mêmes de confirmer le diagnostic.

Pour 24 cas, des résultats d’examens complémentaires étaient données à GPT-4 dans un second temps pour qu’il mette sa réponse à jour. L’exactitude de la localisation et du diagnostic différentiel furent comparés statistiquement entre elles (c.-à-d. l’indépendance des 2 variables) avec un test du Chi2.

Un outil pas encore adapté au diagnostic

GPT-4 a identifié la bonne localisation parmi sa liste de 3 hypothèses dans 48% des 29 cas cliniques et le bon diagnostic dans 52% des cas. Le diagnostic correct était listé en première hypothèse dans 24% des cas. Après l’ajout de résultats d’examens complémentaires, les performances diminuaient : 42% pour la localisation et 42% pour le diagnostic (avec le bon diagnostic listé en première hypothèse dans 25% des cas). À l’analyse statistique par test du Chi2, l’exactitude de la localisation et celle du diagnostic étaient significativement indépendantes l’une de l’autre.

Pour le groupe de 17 cas « simples », la localisation correcte était listée dans 59% des cas contre 33% dans les 12 cas « difficiles ». Les résultats d’examens complémentaires augmentaient la performance à 67% pour les cas « simples », mais l’effondraient à 0% pour les cas « difficiles ». Le diagnostic correct était listé dans 65% des cas « simples » (en première hypothèse dans 41% des cas), mais n’était que de 47% avec l’ajout de résultats complémentaires. Il ne l’était que dans 33% des cas « difficiles », sans amélioration par les résultats d’examens complémentaires.

Les auteurs ont secondairement resoumis les cas cliniques à GPT-4 en donnant l’ensemble des informations (anamnèse, clinique et paraclinique) dès la première instruction. La localisation correcte était listée dans 88% des cas et le bon diagnostic dans 63% des cas.

Une première étude de GPT-4 en neurologie

Il s’agit de la première étude évaluant GPT-4 sur des cas cliniques de neurologie, tant sur la systématisation du tableau clinique que du diagnostic étiologique. La baisse de performance après l’ajout de résultats d’examens complémentaires pour les cas « difficiles » paraît contre-intuitive mais peut être expliquée par le fait que la difficulté des cas clinique venait des résultats complémentaires qui étaient intentionnellement peu contributifs ou trompeurs. Par exemple un cas d’infarctus de l’artère spinale antérieure donnait une première IRM cervicale normale, notamment en T2, mais réalisée sans séquence de diffusion. La saisie d’images en entrée n’était pas encore possible avec la version de GPT-4 testée (mars 2023), mais l’objectif était d’évaluer le raisonnement clinique de GPT-4 sur le tableau clinique en priorité. Toutefois, les informations d’anamnèse et d’examens ont déjà été triées et résumées par l’auteur, ce qui fait que l’aspect pragmatique de l’interrogatoire et de l’examen clinique n’a pas été évalué.

Les résultats d’examens complémentaires fournis n’étaient pas forcément ceux des examens suggérés par GPT-4, ce qui peut avoir perturbé son raisonnement. Le raisonnement probabiliste était généralement plus difficile, mais des examens complémentaires normaux n’éliminaient pas systématiquement le diagnostic correct de la liste, comme un LCR normal dans un cas de cérébellite paranéoplasique.

Les auteurs font le parallèle de l’influence des résultats d’examens complémentaires sur GPT-4 avec celle qu’ils ont sur les internes, qui manquent généralement de confiance dans leur examen clinique. Ils annoncent également avoir comparé GPT-3 avec des systèmes experts listant des diagnostics différentiels à partir de listes de symptômes avec une nette supériorité du premier (Levine et al., 2023).

Conclusion

En sommes, cette étude sur quelques cas cliniques conçus à visée pédagogique montre de faibles performances de GPT-4 pour systématiser des tableaux cliniques neurologiques et suggérer des diagnostics étiologiques. Néanmoins, il faut garder à l’esprit que GPT-4 n’a pas été entrainé spécifiquement pour cette tâche à l’inverse d’autres algorithmes.

L’indépendance de l’exactitude de la localisation et du diagnostic montre que GPT-4 ne raisonne pas en systématisant le tableau clinique. Cet aspect de boite noire pose un problème d’intégration en pratique clinique, là où une IA pratiquant le même raisonnement que le neurologue lui paraîtrait plus explicable et donc critiquable. A ce stade, les usages médicaux des grands modèles de langage semblent donc à restreindre à des tâches cognitives de bas niveau ne demandant pas de décrire un raisonnement, tel que la production ou la lecture de documents.

Références

Galetta, K., Meltzer, E., 2023. Does GPT-4 have neurophobia? Localization and diagnostic accuracy of an artificial intelligence-powered chatbot in clinical vignettes. J Neurol Sci 453, 120804. https://doi.org/10.1016/j.jns.2023.120804

Jozefowicz, R.F., 1994. Neurophobia: The Fear of Neurology Among Medical Students. Archives of Neurology 51, 328–329. https://doi.org/10.1001/archneur.1994.00540160018003

Lee, P., Bubeck, S., Petro, J., 2023. Benefits, Limits, and Risks of GPT-4 as an AI Chatbot for Medicine. New England Journal of Medicine 388, 1233–1239. https://doi.org/10.1056/NEJMsr2214184

Levine, D.M., Tuwani, R., Kompa, B., Varma, A., Finlayson, S.G., Mehrotra, A., Beam, A., 2023. The Diagnostic and Triage Accuracy of the GPT-3 Artificial Intelligence Model. medRxiv 2023.01.30.23285067. https://doi.org/10.1101/2023.01.30.23285067

Meltzer, E., 2022. How to Think Like a Neurologist: A Case-Based Guide to Clinical Reasoning in Neurology. Oxford University Press. https://doi.org/10.1093/med/9780197576663.001.0001